背景

基于当前社会媒体环境以及公司的业务发展, 研究创新型直播方向, 增加品牌自媒体的动作, 利用短视频以及直播工具, 通过虚拟人物向用户传递品牌声音等, 以获取用户增长, 助力帮助短视频增粉

角色面部实时捕捉技术方案实现可以做什么?

随着国内元宇宙的风口渐盛和直播需求的上升,“虚拟主播”似乎坐上了发展的快车道,成为了直播带货的新趋势,虚拟主播属于服务型虚拟人的一种,其核心作用是能替代真人服务,完成内容生产以及一些简单的工作,降低已有服务型产业的成本,“真人+虚拟人”的组合模式。这类虚拟主播往往自带流量,已经形成一定的IP号召力,会起到1+1>2的直播效果

a. 直播使用虚拟形象

b. 不愿意露脸的同事也可以使用虚拟形象

c. 短视频中使用定制的虚拟形象,打造品牌,无需露脸

d. 使用在家政业务角色上,提升效率,节省掉给角色手动K帧的时间

本篇文章使用工具

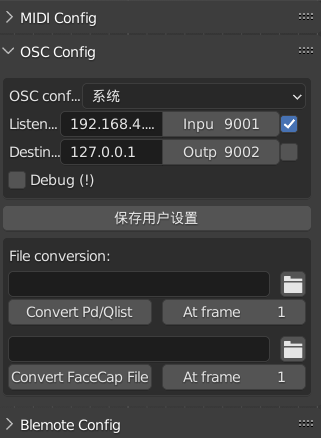

使用软件:Blender

使用插件:Mixamo to blender、Face Cap、AddRoutes、Auto-Rig Pro

为了制作这篇文章,专门制作了一个案例,下面是目录结构

一、头脑风暴、角色构思

二、绘制草图

三、制作模型、模型上色

四、绑定模型

五、输出

一、头脑风暴、角色构思

a. 面部实时捕捉的前提必须有个角色,首先想到的是公司的IP U宝,但是U宝和冰墩墩一样缺少一些结构(口腔、舌头、牙齿),鼻子比较特殊不太好搞

b. 然后想到目前正在做的家政角色组件,但是大家对这个角色不熟悉

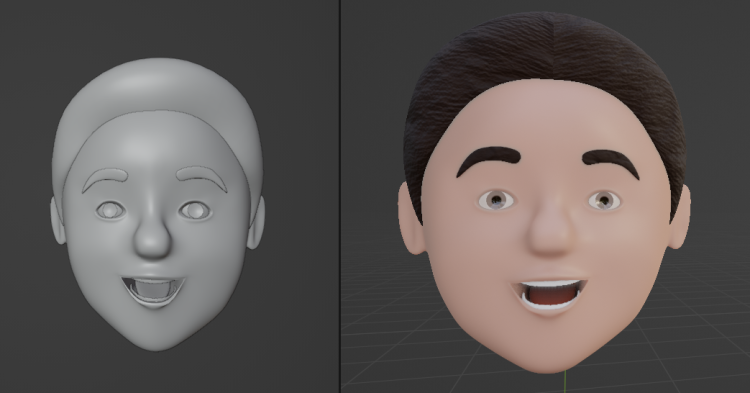

c. 后来想到了老大,大家都认识,老大本身就很亲切,所以决定制作老大的虚拟形象

二、绘制草图

a. 搜集老大的照片素材并整理出正视图和侧视图,方便建模时候参考

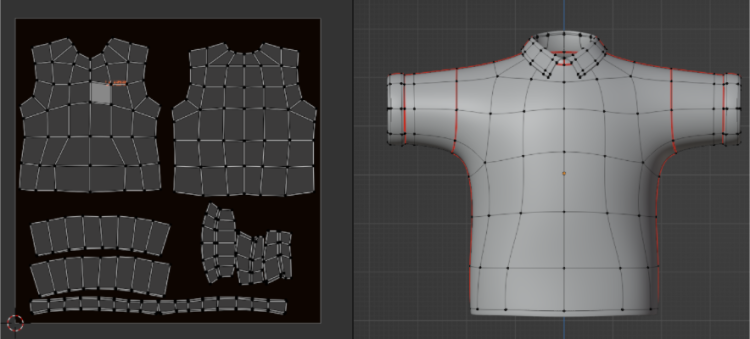

三、制作模型、模型上

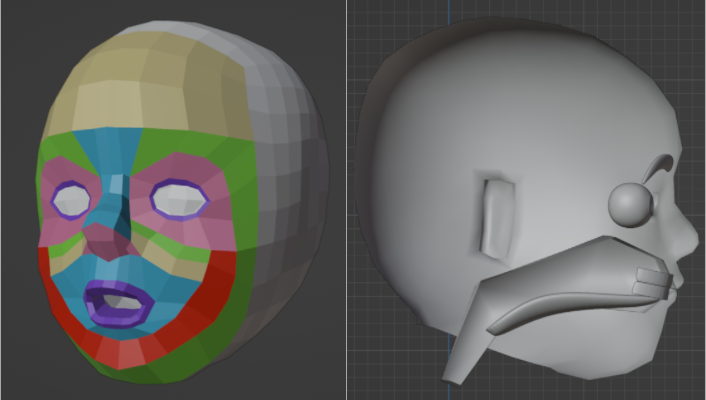

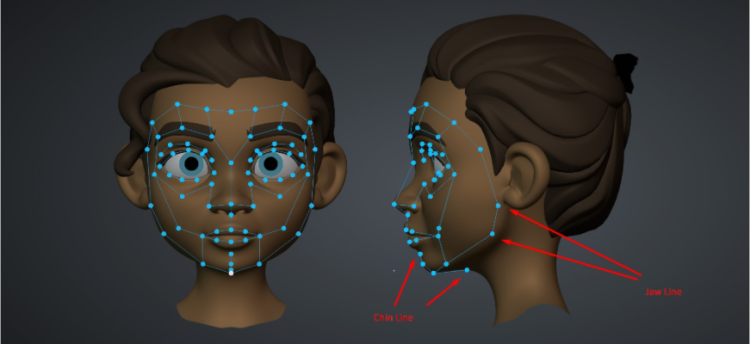

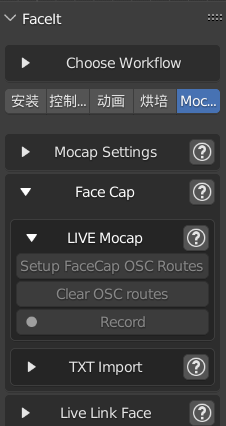

a. 实现制作灵魂,虚拟人的面部,涉及到面部建模、布线技巧,还需要建立空腔、牙齿、舌头、眼珠、视网膜、眉毛元素以支撑面部表情的绑定

四、绑定模型

绑定模型的方法有以下几种:

a. Blender自带的插件Rigfy(缺点:前期绑定比较耗时间)

b. Autorig pro(优点:前期绑定比较简单、快速)

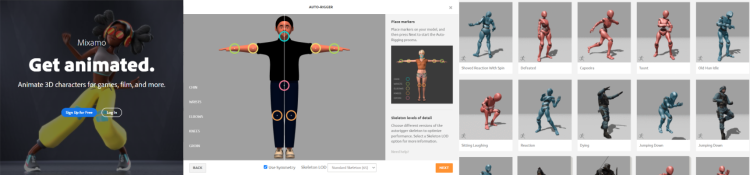

c. Mixamo(需要导出模型至Mixamo网站绑定,优点:可以套用官方一些做好的动画)

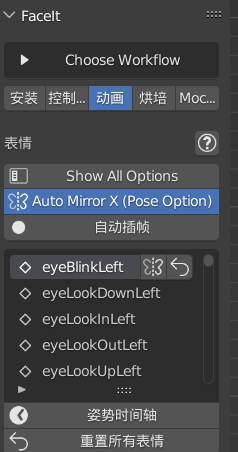

d. Face cap(本篇文章重点:面部实时捕捉的插件,可使用iPhone摄像头实时捕捉真人的面部表情,然后映射到电脑端角色模型上)

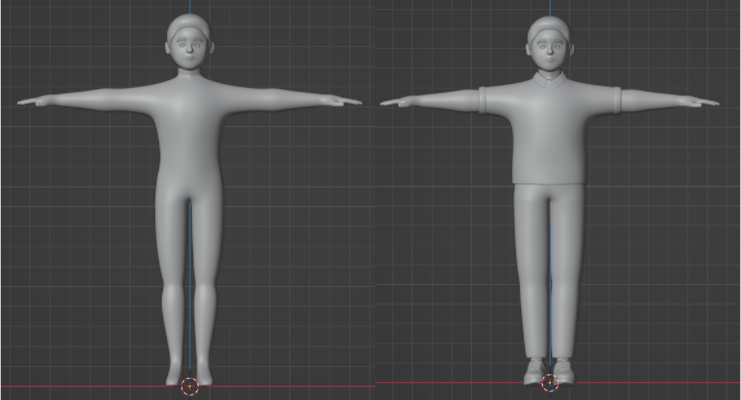

本次身体使用了mixamo to blender绑定了骨骼,方便导出一些有趣的模板动画,节省时间,可以输出有代表性的姿势

面部实时捕捉流程,重点在这里

面部使用Face cap绑定,以下是实现流程

a. 首先要分离模型(按照英文去命名,和插件或绑定骨骼会更加匹配)

分离头部_Head(头发_hair和头部装饰物是不需要注册到插件里的,所以要和头部分开分离)

眼睛_眼膜_Retina(眼睛是分左右的,要分开分离)

Left Retina

Right Retina

眼睛_后面的眼球(眼睛是分左右的,要分开分离)

Left Eyeball

Right Eyeball

眉毛Brow(可以分离为1个眉毛,不用分开)

牙齿Teeth

Upper Teeth

Lower Teeth

舌头Tongue

b. 分离后把眉毛、眼球、视网膜、牙齿、舌头注册到插件里,并注册顶点组

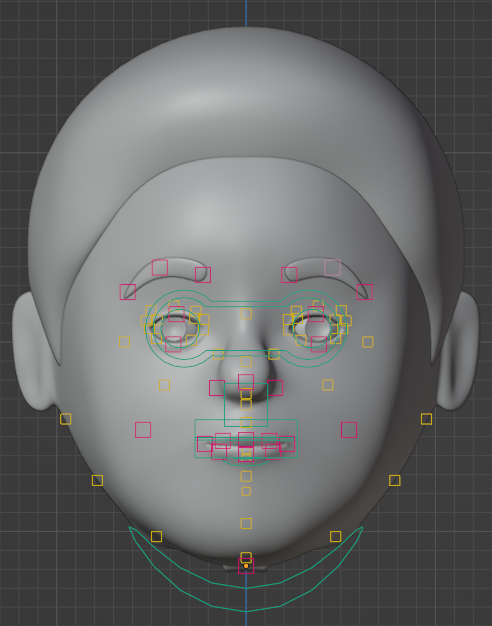

c. 然后是生成面部坐标,把坐标对应到相应的面部肌肉上,再点击绑定就会生成一副控制器

d. 接下来是面部表情的一些动画测试,方便发现和纠正问题

e. 然后烘焙动画

f. 最后电脑端IP地址,手机端输入电脑的IP地址,即可完成连接

五、输出效果图

a. 可输出想要的动作姿势

1.实时捕捉面部

2.实时捕捉面部和头部

本项目还有后续,因为需要落实应用在短视频、直播和项目上,所以还会进行下相关研究和实验应用,小编会持续更新,请大家持续关注!

— UU跑腿设计中心

谢谢观看~